Чтобы помочь поисковым системам правильно индексировать ваш блог, нужно сделать правильный файл Robots txt для WordPress. Посмотрим как его создать и чем наполнить.

Что дает Robots.txt?

Он нужен для поисковых систем, для правильной индексации ими веб-ресурса. Содержимое файла “говорит” поисковому роботу, какие страницы нужно показывать в поиске, а какие скрыть. Это позволяет управлять контентом в поисковой выдаче.

Важность robots.txt для WordPress неоценима, так как этот текстовый файл позволяет нацелить поисковую систему на попадание нужного контента сайта в выдачу результатов.

Например, при запросе в Гугле “купить холодильник” конечному покупателю незачем попадать на страницу администрирования магазина. Ему важно перейти сразу в раздел “Холодильники”.

Наполнять robots.txt нужно уже на этапе разработки сайта. Его изменения вступают в силу не сразу. Может пройти неделя или несколько месяцев.

Где находится Robots?

Этот обычный тестовый файл лежит в корневом каталоге сайта. Его можно получить по адресу

https://site.ru/robots.txt

Движок изначально Роботс не создает. Это нужно делать вручную или пользоваться инструментами, которые создают его автоматически.

Не могу найти этот файл

Если по указанному адресу содержимое файл отображается, но на сервере его нет, то значит он создан виртуально. Поисковику все равно. Главное, чтобы он был доступен.

Из чего состоит

Из 4 основных директив:

- User-agent — правила поисковым роботам.

- Disalow — запрещает доступ.

- Allow — разрешает.

- Sitemap — полный URL-адрес карты XML.

Правильный robots.txt для ВордПресс

Вариантов много. Инструкции на каждом сайте отличаются.

Вот пример корректного robots.txt, в котором учтены все разделы сайта. Коротко разберем директивы.

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-content/cache

Disallow: /wp-json/

Disallow: /wp-login.php

Disallow: /wp-register.php

Disallow: /xmlrpc.php

Disallow: /license.txt

Disallow: /readme.html

Disallow: /trackback/

Disallow: /comments/feed/

Disallow: /*?replytocom

Disallow: */feed

Disallow: */rss

Disallow: /author/

Disallow: /?

Disallow: /*?

Disallow: /?s=

Disallow: *&s=

Disallow: /search

Disallow: *?attachment_id=

Allow: /*.css

Allow: /*.js

Allow: /wp-content/uploads/

Allow: /wp-content/themes/

Allow: /wp-content/plugins/

Sitemap: https://site.ru/sitemap_index.xml

В первой строке указывается, что ресурс доступен для всех поисковых роботов (краулеров).

Директивы Disallow запрещают выдавать в поиске служебные каталоги и файлы, закэшированные страницы, разделы авторизации и регистрации, ленты RSS (Feed), страницы авторов, поиска и вложений.

Allow разрешают добавлять в индекс скрипты, стили, файлы загрузок, тем и плагинов.

Последняя – это адрес XML-карты.

Директива Host с указанием адреса сайта устарела, поэтому добавлять ее в ваш роботс смысла нет.

Как создать robots.txt для сайта

Рассмотрим несколько методов: вручную и с помощью WordPress-плагинов.

При изменении файла robots.txt, вы не сразу заметите результаты. Для этого понадобится от одного до нескольких месяцев (все зависит от поисковой системы). Поэтому рекомендую составлять корректный роботс уже на стадии разработки сайта.

Вручную

Это можно сделать например, в Блокноте (если локальный сервер) или через FTP-клиент (на хостинге).

Вручную добавить robots.txt на сайт проще всего по FTP. Для этого необходимо создать сам файл в текстовом формате. Затем, воспользовавшись одним из FTP-клиентов (например, FileZilla), загрузить robots.txt в корневую папку сайта (рядом с файлами wp-config.php, wp-settings.php).

Перед загрузкой файла нужно узнать у вашей хостинг-компании IP-адрес, за которым закреплен сайт, имя FTP-пользователя и пароль.

После успешной загрузки robots.txt, перейдите по адресу https://ваш_сайт.ru/robots.txt, чтобы посмотреть актуальное состояние файла.

С помощью плагинов

Для облегчения создания robots.txt в WordPress существуют специальные плагины. Некоторые из них: WordPress Robots.txt File, DL Robots.txt, Yoast SEO, All in One SEO Pack.

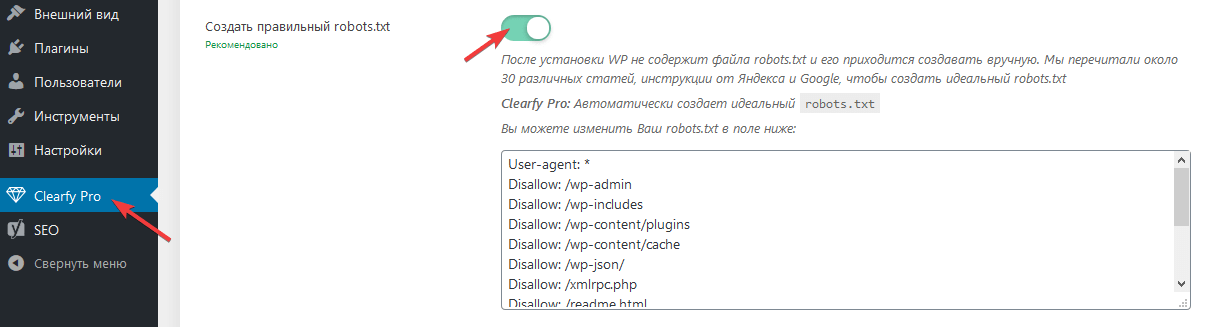

Clearfy Pro

Clearfy Pro создает виртуальный файл. Для этого:

- Перейдите в админ-меню Clearfy Pro.

- На вкладке SEO задействуйте опцию

- Он создастся автоматически. При желании отредактируйте в поле здесь же.

- Сохраните изменения.

Всегда можно отредактировать содержимое Robots. Просто измените/дополните его нужным содержимым и сохраните изменения.

Активировать промокод на 15%

Yoast SEO

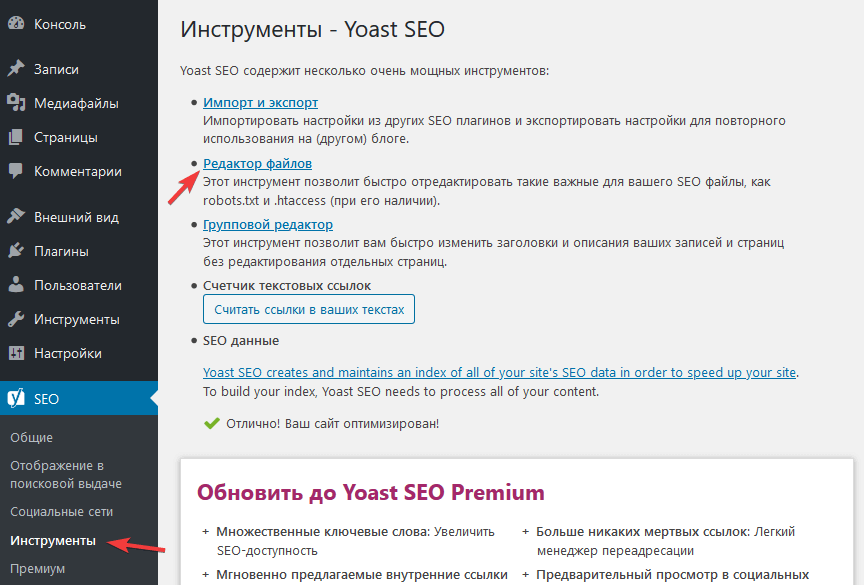

Рассмотрим создание файла robots.txt на примере одного из самых мощных SEO-плагинов Yoast SEO.

Этот мощный СЕО-модуль для WP также решит задачу.

- Перейдите SEO > Инструменты.

- Нажмите Редактор файлов.

- Если в корневом каталоге этого файла нет, кликните Создать файл robots.txt. В редакторе вставьте вышеописанный код и нажмите Сохранить изменения в robots.txt.

Если есть, то откроется редактор для внесения изменений.

- Нажмите Сохранить изменения в robots.txt.

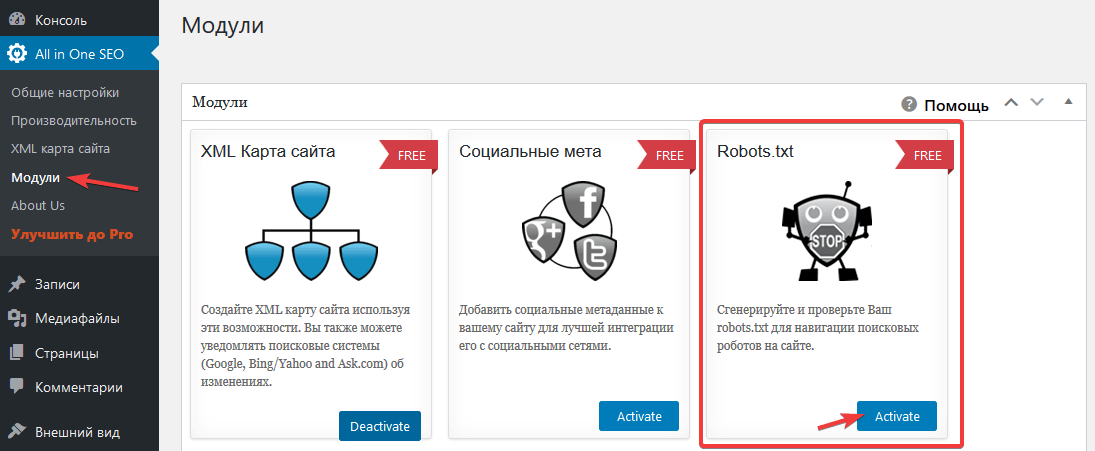

All in One SEO Pack

Это решение тоже “умеет” работать с Robots. Для этого:

- Откройте All in One SEO > Модули.

- Выберите одноименное название модуля и нажмите Activate.

- Перейдите All in One SEO > Robots.txt.

- В полях добавьте директивы.

Настройка для интернет-магазинов (WooCommerce)

Для WordPress-ресурсов с использованием этого расширения просто добавьте эти правила:

Disallow: /cart/

Disallow: /checkout/

Disallow: /*add-to-cart=*

Disallow: /my-account/Нажмите, пожалуйста, на одну из кнопок, чтобы узнать понравилась статья или нет.

А что значит User-agent? У Вас он только один и в виде звездочки, а в этой статье https://dampi.ru/pravilnyiy-robots-txt-dlya-sayta-na-wordpress их куча и всяких разных

Статья по вашей ссылке 2017 года. User-agent под звёздочкой означает разрешено для всех поисковиков.

Здравствуйте. срздал роботс с помощью плагина Clearfy Pro в админке плагина все нормально, а вот на сайте выводится Robots.txt. с двумя строчками Sitemap. Вот ссылка https://webnub.ru/robots.txt. Подскажите как исправить данный глюк?